LLM(Large Language Model, 대규모 언어 모델)은 Chat GPT처럼 사용자의 질문을 이해하고, 제안하거나 대화할 수 있는 챗봇을 의미합니다. 마치 사람이 작성한 것처럼 텍스트를 처리하고 작성할 수 있어서, 최근 다양한 산업에서 적극적으로 사용하는 기술입니다.

하지만 LLM도 완벽하지는 않습니다. 최대한 고품질의 결과물을 얻기 위해서는 모델의 장점과 한계에 대한 심층적인 이해가 필요한데요. 도메인 지식을 포함해 다양한 데이터를 큐레이션할 뿐만 아니라, 지속적인 모니터링과 개선 등 다양한 활동이 필요하죠.

NVIDIA Blackwell 플랫폼은 Generative AI의 구축과 성능 개선을 위해 만들어진 솔루션입니다. 최대 10조 개의 매개변수를 가진 모델까지 실시간으로 처리할 수 있는 능력을 가지고 있죠. 이를 기반으로 AI 학습과 추론 능력을 크게 개선할 수 있다는 평가를 받고 있습니다.

NVIDIA의 설립자이자 CEO인 젠슨 황(Jenson Huang)은 Blackwell 플랫폼이 Generative AI라는 새로운 산업혁명에 새로운 동력이 되어줄 것이라고 말하는데요. 이 글에서는 효율적으로 모델의 성능을 개선하고 고성능 AI를 구축할 수 있는 Blackwell 플랫폼에 대해 소개하겠습니다.

LLM 컴퓨팅 파워 향상

강력한 병렬 처리 능력

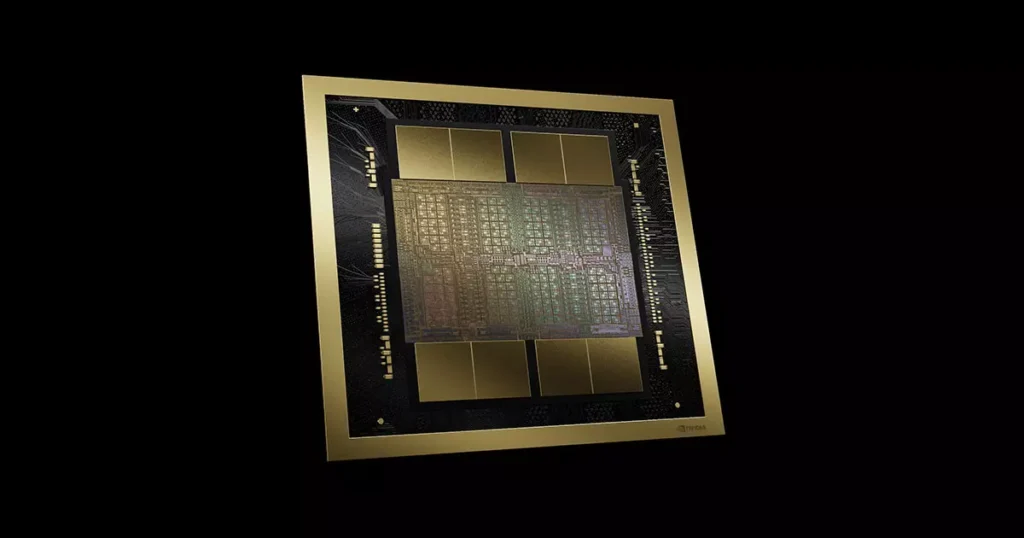

Blackwell GPU는 2,080억 개의 트랜지스터를 탑재한 초고성능 칩입니다. 이전 세대인 Hopper 아키텍처와 비교해도 크게 향상된 수치를 자랑하는데요. 더욱 고도화된 AI 워크로드 구현을 희망하는 기업에게 특히 주목 받고 있습니다.

Blackwell GPU는 TSMC의 4NP (4nm) 공정을 사용해 제작되었습니다. 이 말은, 더 작은 트랜지스터들이 더 높은 밀도로 집적해서 성능과 에너지 효율성을 동시에 개선했다는 뜻입니다.

특히 GPU Die를 초당 10TB 속도로 연결한 단일 GPU라는 점에 주목할 필요가 있습니다. 이런 Multi Dies 설계는 대규모 병렬 처리가 필요한 LLM 워크로드에 가장 특화되어 있다는 평가를 받고 있죠.

LLM 학습에 최적화

Blackwell GPU는 100B 파라미터 규모의 LLM 모델을 학습할 때, 이전 세대 대비 최대 4배 빠른 속도를 제공할 수 있습니다. 이를 통해 모델 개발 주기를 크게 단축시키고, 더 큰 규모의 모델 실험이 가능해졌죠.

추론 과정을 개선할 때도 Blackwell GPU가 큰 활약을 하고 있습니다. 특히 배치 크기가 작은 실시간 추론 시나리오에서, Blackwell은 이전 세대 대비 최대 30배 빠른 처리 속도를 보여줬습니다. 이를 통해 Chat GPT와 같이 대화형 AI 서비스를 구축할 때, 응답 시간을 크게 단축시킬 수 있었습니다.

확장성과 유연성

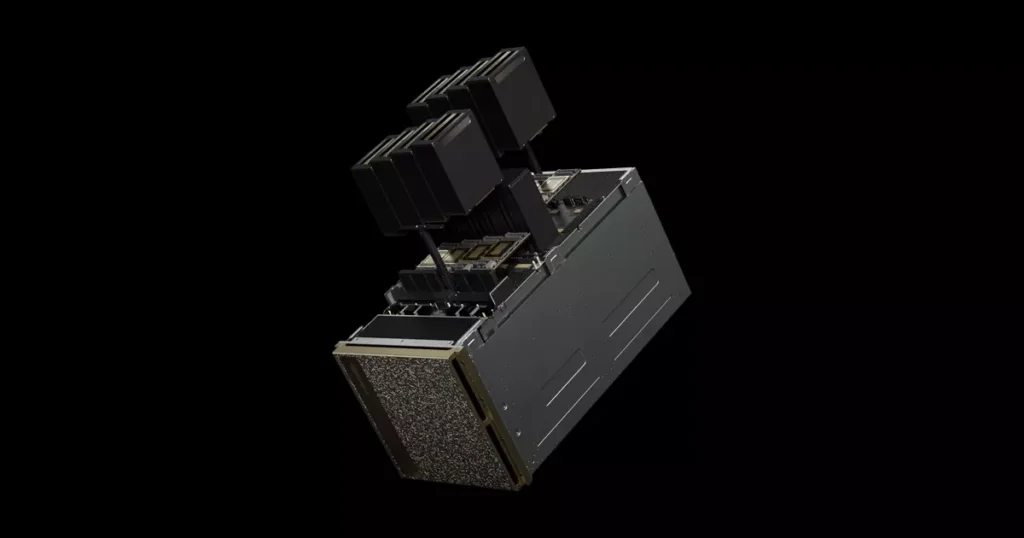

Blackwell GPU 아키텍처는 단일 GPU의 성능도 놀라운 수준이지만, 여러 GPU를 연결하여 더 큰 규모의 컴퓨팅 클러스터를 구성할 수 있다는 점에서도 뛰어난 성과를 보여주고 있습니다. 수천 억 개 이상의 파라미터를 가진 초대규모 LLM 모델의 학습과 운영에 특화되어 있습니다.

또한 Blackwell GPU는 다양한 정밀도(precision)의 연산이 가능합니다. FP64, FP32, FP16, INT8 등 다양한 데이터 타입에 대한 최적화된 성능을 제공하는데요. BlackWell GPU를 활용하면 LLM 개발자들의 골칫거리였던 정확도와 성능 사이의 균형에 대한 해답을 찾을 수 있겠죠.

LLM 추론 효율성의 극대화

Blackwell 아키텍처의 핵심 혁신 중 하나는 개선된 2세대 Transformer 엔진입니다. Transformer 아키텍처는 현대 LLM의 근간을 이루는 핵심 요소인데요. 이를 하드웨어 레벨에서 최적화한 Transformer 엔진은 LLM의 성능과 효율성을 크게 향상시켰습니다.

2세대 Transformer 엔진에는 마이크로 텐서 스케일링 기술이 도입되었습니다. 이를 통해 Transformer 모델의 핵심 연산인 행렬 곱셈을 더욱 효율적으로 처리할 수 있었죠. 마이크로 텐서 스케일링을 통해 여러 개의 작은 텐서 연산으로 분할하여 처리함으로써, GPU의 병렬 처리 능력을 극대화했습니다.

이 기술의 도입으로 Blackwell GPU는 이전 세대 대비 2배 이상의 Transformer 처리 성능을 제공합니다. 실제로, GPT-3 175B와 같은 대규모 모델의 추론 시 최대 30배의 성능 향상을 보여주었다고 하죠.

LLM 시스템 확장을 위한 5세대 NVLink

초고속 GPU 간 통신

현대의 대규모 AI 모델, 특히 수천억 개 이상의 파라미터를 가진 LLM들은 단일 GPU로 처리하기에는 너무 크다는 한계가 있습니다. 결국 여러 GPU, 때로는 수천 개의 GPU에 걸쳐 분산되어 학습되고 실행해야만 했죠.

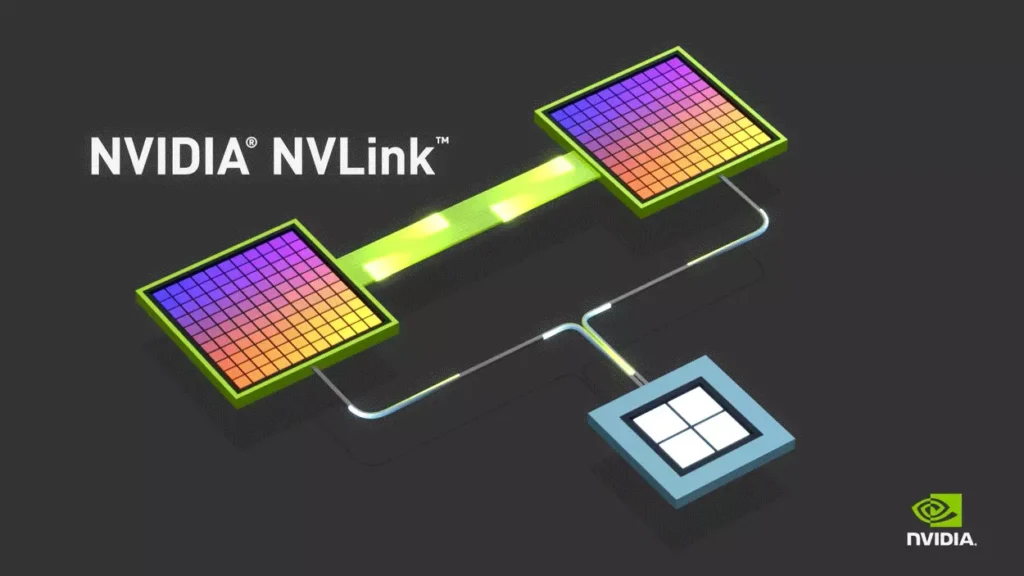

따라서 이 과정의 효율성을 개선하기 위해서는 GPU 간 고속 통신이 반드시 필요했습니다. NVIDIA는 이를 위해 Blackwell 아키텍처와 함께 5세대 NVLink 기술을 도입하게 되었죠.

5세대 NVLink는 GPU당 1.8TB/s의 양방향 처리가 가능합니다. 이는 이전 세대 대비 2배 이상 향상된 수치로, 대규모 LLM의 분산 학습과 추론에 있어 획기적으로 성능을 향상할 수 있었습니다.

대규모 GPU 클러스터

5세대 NVLink의 또 다른 중요한 특징은 최대 576개의 GPU를 직접 연결할 수 있다는 점인데요. 이전 세대의 256개보다 크게 늘어난 수치로, 초대규모 AI 모델의 학습과 운영을 위한 새로운 가능성을 보여줍니다.

576개의 Blackwell GPU를 연결하면 이론상 총 1.4 엑사플롭스(exaflops)의 AI 성능과 30TB의 고속 메모리를 갖춘 단일 슈퍼컴퓨터급 시스템을 구성할 수 있다고 하빈다. 기존에는 상상조차 하기 어려웠던, 대규모의 LLM을 학습하고 운영할 수 있다는 의미로 연결되죠.

전문가 혼합 모델(Mixture of Experts, MoE) 지원 강화

5세대 NVLink의 고속 통신 능력은 이게 끝이 아닙니다. 전문가 혼합 모델(MoE)과 같은 복잡한 AI 아키텍처를 효율적으로 구현할 수 있다는 장점이 있는데요.

MoE 모델은 여러 개의 “전문가” 네트워크로 구성되며, 입력에 따라 적절한 전문가를 동적으로 선택하여 처리하고 있습니다. 이 구조는 모델의 용량을 크게 늘리면서도 계산 효율성을 유지할 수 있어, 최근 LLM 연구에서 주목받고 있죠.

실제로 입력에 따라 적절한 전문가를 선택하는 과정에서, 동적 라우팅 효율성이 크게 향상된 것을 알 수 있었습니다. 여러 GPU에 분산된 전문가 네트워크 간의 효율적인 작업 분배가 가능해졌기 때문인데요. 이러한 개선점들은 GPT-4나 PaLM처럼 최신 LLM이 채택한 MoE 아키텍처의 성능을 한층 끌어올릴 수 있다는 점에서 많은 개발자들의 주목을 받고 있습니다.

결론 및 요약

이외에도 Blackwell GPU의 하드웨어 최적화가 LLM 성능 향상에 주는 영향을 요약하면 아래와 같습니다. 자세한 내용은 NVIDIA의 공식 뉴스룸에서 확인하실 수 있습니다.

- FP4 정밀도 지원

- 4비트 부동소수점(FP4) 연산을 지원하여 메모리 대역폭과 계산 효율성을 크게 향상시켰습니다. 이를 통해 동일한 하드웨어에서 2배 더 큰 모델을 실행할 수 있게 되었습니다.

- 마이크로 텐서 스케일링

- 미세한 단위의 텐서 스케일링 기법을 도입하여 정확도를 유지하면서 성능을 최적화했습니다. 결과적으로 동적 범위 관리 알고리즘과 결합되어 FP4 연산의 정확도 손실을 최소화합니다.

- 커스텀 텐서 코어 기술

- Blackwell 전용 텐서 코어 기술을 사용하여 LLM과 MoE(Mixture-of-Experts) 모델의 추론 및 학습 속도를 가속화했습니다.

- 메모리 대역폭 향상

- HBM3e 메모리를 사용하여 메모리 대역폭을 크게 향상시켰습니다. 이를 통해 더 큰 모델을 더 빠르게 처리할 수 있게 되었습니다.

- NVLink 개선

- 5세대 NVLink를 통해 GPU 간 통신 속도를 1.8TB/s로 향상시켰습니다. 이는 대규모 분산 학습 및 추론에 필수적입니다.

NVIDIA Blackwell 플랫폼은 LLM을 새로운 수준의 규모, 성능, 효율성 및 보안으로 끌어올렸습니다. 전문가들은 이를 더욱 강력하고 지능적인 AI 시스템의 개발을 촉진하고, 더 넓은 산업에 AI가 도입되는 계기가 될 것으로 보고 있습니다.

다만 NVIDIA Blackwell 플랫폼의 혁신성은 뛰어나지만, 모든 조직이나 프로젝트에 똑같이 적합하다고는 볼 수 없습니다. 적합한 솔루션을 찾기 위해서는 각 도메인과 산업의 특성에 맞는 적절한 설계가 필요합니다.

결국 AI 기술의 진정한 가치는 실제로 비즈니스가 갖고 있는 문제를 해결하거나, 혁신을 가져오는 데에 있습니다. 이에 따라 아이크래프트는 가장 비싸고 좋은 하드웨어만을 권하는 것이 아니라, 고객사에게 적합한 솔루션을 제시하고자 노력하고 있습니다.

함께 읽으면 좋은 콘텐츠