2023년 6월, 마이크로소프트의 클라우드 서비스인 Azure에서 발생한 네트워크 장애로 서비스 전체가 중단된 사태가 있었습니다. 사건의 전말은 클라우드 네트워크 장비를 업데이트하는 과정에서 오류가 발생했던 것인데요. 문제가 발생하면 자동으로 시스템을 수정하는 소프트웨어의 오류까지 겹쳐지면서 잘못된 기술 지원으로 더 큰 혼란이 일어났었죠.

해당 사건으로 인해, 클라우드 컴퓨팅의 네트워크 성능과 안전성에 대한 우려가 제기되기도 했습니다. 특히 자동화 시스템의 오류가 문제를 더욱 악화시켰다는 점에서, 클라우드 환경에서 네트워크 관리에 여전히 아쉬운 점이 많다는 전문가들의 지적도 있었죠.

클라우드 환경에서 네트워크 성능은 여전히 완벽하게 해결되지 않고 있습니다. 특히, 여러 클라우드를 동시에 사용하는 멀티 클라우드 환경에서는 더더욱 성능을 유지하기가 어렵다는 실무자들의 의견이 많습니다.

이에 따라 NVIDIA는 클라우드 네트워크의 성능 문제를 극복하기 위해 다양한 전략을 통해 개선하고 있습니다.

- AI 워크로드에 최적화된 엔드-투-엔드 이더넷 솔루션

- 엔터프라이즈 고객을 위한 고성능 네트워킹 솔루션

- Magnum IO을 기반으로 HPC 시스템의 네트워크 성능을 향상

- 브라우저를 통해 즉시 접근 가능한 AI 슈퍼컴퓨팅 서비스

- NIM(NVIDIA Inference Microservices)

이 글에서는 NVIDIA가 클라우드 네트워크의 약점을 보완하기 위해 시도하고 있는 전략 중 ConnectX SmartNIC 기술과 RDMA over Converged Ethernet((ROCE)에 대해서 설명하겠습니다. 또한 클라우드 워크로드를 최적화하기 위한 기술적 개선과 보완에 대해 소개합니다.

NVIDIA의 핵심 클라우드 네트워크 기술

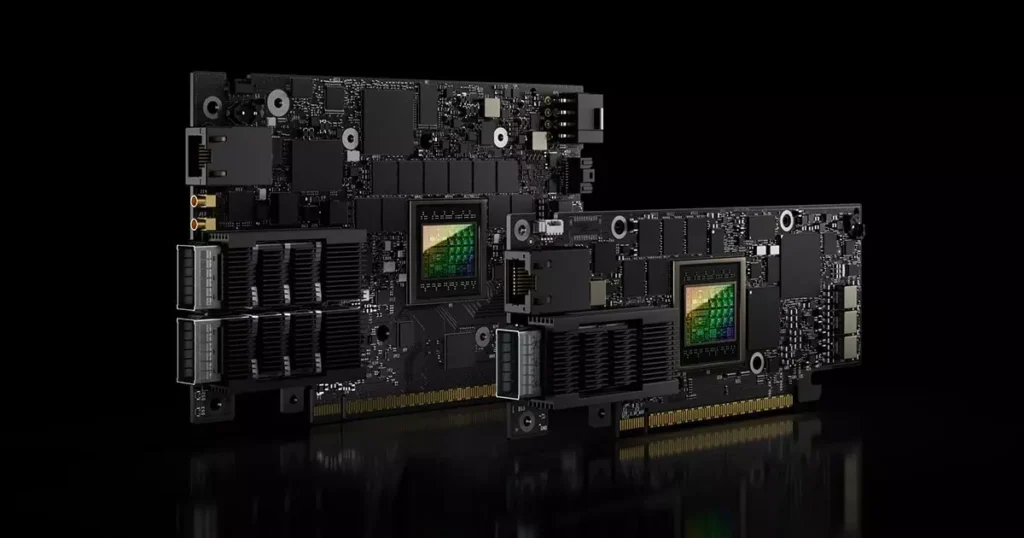

ConnectX SmartNIC

Smart NIC는 스마트 네트워크 인터페이스 카드(Smart Network Interface Card)의 약자로, 데이터센터의 네트워킹이나 보안, 스토리지 작업을 효율적이고 유연하게 처리하게 하는 가속기입니다.

ConnectX SmartNIC을 사용하면,서버 CPU에서 처리했던 많은 네트워크 관련 작업을 오프로드하여, 전체 시스템 성능을 향상할 수 있죠. .10GB/s부터 최대 400GB/s까지의 이더넷 속도를 기반으로, 처리량이 많고 복잡한 애플리케이션에 특화되어 있습니다.

특히 NVIDIA의 멀티 호스트 기술을 통해 직접 데이터 액세스가 가능해졌습니다. 이에 따라 대기 시간을 단축하고, 서버의 밀도를 높일 수 있다는 장점이 있죠.

이외에도 SR-IOV, VirtIO 등의 가상화 기술을 통해 클라우드 환경에서 네트워크 성능을 최적화할 수 있다는 장점이 있습니다.

일반적으로 Smart NIC는 복잡한 네트워크 기능이 필요하거나, 다양한 프로토콜 지원이 필요한 경우에 활용하고 있습니다. 여러 네트워크 및 스토리지 프로토콜을 동시에 지원해야 하는 환경에서 가장 유리하게 사용할 수 있습니다.

RDMA over Converged Ethernet (RoCE)

RDMA over Converged Ethernet(RoCE)는 표준 이더넷 네트워크를 기반으로 Remote Direct Memory Access (RDMA) 기능을 제공하는 네트워크 프로토콜을 의미합니다.

RoCE는 데이터를 전송할 때 운영 체제 커널을 우회하여, 네트워크 어댑터가 직접 애플리케이션 메모리에 접근할 수 있도록 합니다. 이 덕분에 CPU의 개입을 줄이고, 지연 시간을 크게 단축시킬 수 있었죠. 실제로, RoCE v2를 사용하면 지연 시간을 1-2초 마이크로초 수준까지도 낮출 수 있습니다.

또한 CPU의 오버헤드가 감소함에 따라 네트워크 어댑터가 더 높은 처리량을 달성할 수 있게 되었습니다. NVIDIA ConnectX-6 Dx 어댑터의 경우, 최대 200Gb/s의 대역폭을 지원하는데요. 대규모 데이터 처리나 전송이 필요한 기업에게 최적화되어 있죠.

특히 클라우드 환경의 개선에도 좋은 성과를 보이고 있습니다. RoCE는 표준 이더넷 인프라를 사용하기 때문에, 기존 네트워크 구조를 크게 변경하지 않고도 RDMA의 이점을 얻을 수 있죠. 이런 장점을 통해, 특별한 네트워크 장비 없이도 쉽게 시스템을 확장할 수 있고 고성능 네트워크 솔루션을 구축할 수 있게 되었습니다.

RoCE는 초저지연 통신이 필요하거나 대규모 데이터 전송이 빈번한 경우에 가장 최적화되어 있습니다. 빅데이터를 분석하거나, AI/ML 워크로드와 같이 대용량 데이터를 처리해야 할 때 적합하죠. 또한 당장 CPU 과부하를 줄이고 애플리케이션 성능을 즉각적으로 개선해야 하는 환경에 유용합니다.

NVIDIA의 클라우드 네트워크 최적화

NVIDIA의 네트워크 기술은 다양한 클라우드 워크로드의 성능을 크게 개선하고 있습니다. 여기서는 앞에서 설명했던 ConnectX SmartNIC과 RDMA over Converged Ethernet (RoCE)을 통한 클라우드 네트워크 최적화에 대해 더 구체적으로 알아보겠습니다.

HPC 성능 향상 사례

HPC(High Performance Computing) 환경은 대규모의 계산 작업을 수행하기 위해 설계된 고성능 컴퓨팅 시스템을 의미합니다. 이 환경에서는 노드 간 빠른 데이터 전송을 위해 저지연 네트워크 인프라를 갖추는 것이 가장 중요합니다.

이때 ConnectX SmartNIC과 RoCE 기술을 함께 사용하면, 지연 속도를 낮추면서 고대역폭의 통신이 가능해져 보다 고도화된 애플리케이션을 구축할 수 있다는 장점이 있습니다.

RoCE 기술은 노드 간 통신 지연 시간을 마이크로초 단위로 낮춰서 복잡한 계산 작업의 전체 실행 시간을 낮출 수 있습니다. RoCE v2와 Priority Flow Control (PFC)과 결합하면, 네트워크 혼잡 현상을 효과적으로 관리할 수 있죠. 이는 대규모 HPC 클러스터에서 중요한 역할을 하고 있습니다.

이외에도 ConnectX SmartNIC의 하드웨어 오프로딩 기능을 통해 MPI 작업을 가속화하고, HPC 클러스터의 확장성을 개선할 수 있습니다. 특히, AllReduce, Broadcast와 같은 MPI 집합 통신 연산을 하드웨어에서 직접 처리하여 CPU 개입을 최소화하고 통신 효율성을 극대화할 수 있죠.

AI 및 머신러닝 워크로드 개선

여전히 많은 IT 기업이 AI 및 머신러닝의 분산 학습과 추론 성능을 향상시키기 위해 다양한 방법을 도모하고 있습니다. NVIDIA는 GPU-Direct RDMA와 연계한 ConnectX SmartNIC 기술을 통해 GPU 간 직접 통신을 구현해냈습니다.

대규모 언어 모델 학습은 복잡한 학습 구조 탓에 모델 성능을 개선하는 것이 쉽지 않은데요. RoCE를 통한 초저지연 통신을 활용하면 동기화 오버헤드를 최소화할 수 있습니다. 파라미터 서버 아키텍처에서 가중치 업데이트를 할 때 효율성이 높아지는 것을 확인할 수 있었죠.

또한 이미지 분류 작업에서 Data Augmentation과 같은 전처리 작업을 진행할 때, SmartNIC을 활용하면 작업 속도와 효율을 개선할 수 있습니다. SmartNIC의 프로그래머블 데이터 경로를 활용하면 전처리 과정의 커스텀 파이프라인을 구축할 수 있습니다.

혹시라도 발생할 수 있는 장애에 대한 대비도 우수한 성과를 보여주고 있는데요. onnectX의 Remote Persistent Memory 지원을 활용하면 대규모 AI 모델이 장기 실행 작업을 하는 동안에도 안정성을 높이고, 장애 복구 시간을 단축시킬 수 있습니다.

데이터베이스 성능 보완

클라우드 환경에서 최적의 데이터베이스 성능을 유지하기 위해서는 네트워크 성능 최적화가 필수적입니다. 네트워크 대역폭이 제한되면 데이터 전송 시 데이터베이스의 성능이 저하될 수도 있죠. 또한 클라우드가 유연하게 네트워크 리소스를 조절할 수 있다면, 데이터베이스 성능에도 긍정적인 영향을 줄 수 있습니다.

NVIDIA의 DOCA 프레임워크를 활용하면 데이터베이스에 특화된 네트워크 기능을 구현할 수 있는데요. 예를 들어, 특정 쿼리 유형에 대해 최적화된 라우팅이나 캐싱 전략이 필요하다면 SmartNIC 레벨에서 구현할 수 있습니다. 자주 액세스되는 데이터에 대한 인-메모리 캐싱이나, 복잡한 연산의 일부를 SmartNIC에서 처리하는 형태의 시스템을 구축하는 것이죠.

이외에도 ConnectX의 Remote Direct Memory Access (RDMA) 기능은 분산 데이터베이스에서 노드 간 데이터 전송 효율성을 크게 높일 수 있습니다. 특히 대규모 데이터 셔플링이 필요한 분석 쿼리에서 특히 유용하게 활용되고 있죠.

NVIDIA 클라우드 네트워크 기술의 발전 방향

아이크래프트는 NVIDIA의 클라우드 네트워크 기술의 발전에 따라, 전 세계적으로 데이터 센터와 클라우드 인프라의 성능이 향상되고 있다고 믿어 의심치 않습니다.

이를 통해, 앞으로도 AI 특화 네트워킹 솔루션의 개발부터 클라우드 네이티브 네트워킹에 대한 발전 역시 지속적으로 혁신할 것이라고 보고 있습니다.

특히 NVIDIA에서 발표한 BlueField-3 DPU(Data Processing Unit)는 클라우드 네트워크 가속화, 컴포터블 스토리지, 제로 트러스트 보안 등의 혁신적인 기능을 기반으로 차세대 클라우드 인프라의 핵심으로 자리잡고 있는데요. 이는 NVIDIA가 클라우드 컴퓨팅의 미래를 어떻게 그리고 있는지를 잘 보여주고 있습니다.

NVIDIA가 클라우드 네트워크 성능 향상을 위한 전략 중 하나는 다양한 클라우드 서비스 제공업체와의 파트너십으로 꼽히고 있습니다. NVIDIA의 기술이 다양한 클라우드 환경에 최적화될 수 있도록, 아이크래프트와 같은 전문 기업과의 협업을 꾸준히 이어가고 있죠.

이에 발맞춰 아이크래프트 역시 NVIDIA의 GPU 및 네트워킹 기술이 클라우드 서비스에 잘 적용될 수 있도록, 적극적으로 기술 개발과 연구에 함께하고 있습니다.

함께 읽으면 좋은 콘텐츠